Фото: shutterstock.com

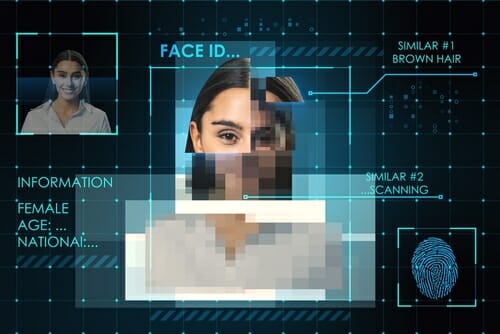

Сәуірдің аяғында қытайлық Tencent Cloud компаниясы Deepfakes-as-a-Service (DFaaS) дижитал платформасын іске қосты. Адамның цифрлық көшірмесін өте дәл жасап береді. Ол үшін бар болғаны 100 шақты сөз айтып, үш минуттық видеоңызды жүктеуіңіз керек. Жалпы дипфейк технология қалай жұмыс істейді? Одан қандай қауіп төнеді? Бүгінгі материалымызда осы туралы айтамыз.

Дипфейк технология деген не?

Осыдан он шақты жыл бұрын дижитал көшірме туралы елестетудің өзі қиын еді. Өйткені көшірме жасау үшін технология емес, грим мен маскалар қолданылады. Соның өзінде барынша шынайы ұқсату қиын еді. Ал технология дамыған сайын дижитал егізіңізді жасау жеңілдеді. Сонда дипфейк деген не? Дипфейк — жасанды медиаконтент (аудио, сурет немесе видео) жасау технология. Ол үшін тереңірек зерттелген алгортимдер қолданылады. Алғашында дипфейтер деп танымал адамдардың бейнесін басқ біреудің бейнесіне қойып, FaceSwap технологиясы арқылы «созып», сол сөйлеп жатқандай түр жасалған контентті айтатын. Ол технология Generative adversarial network немесе GAN желілеріне негізделген еді. GAN екі бөліктен тұрады: генератор және дискриминатор. Бір модель сурет үлгілерінен репликалар генерациялайды, екіншісі сол суреттің шынымен фейк пе, жоқ па екенін анықтауға тырысады. Екінші модель жауап беруге қиналып, анықтай алмай жатса — демек, ол шынында қатты ұқсаған дегенді білдіреді. Егер GANды шағын суреттер базасымен үйретсе, онда фейк екені білінбейтін түрлі күлкілі, провокациялы суреттер шығаруға болады.

Бұл бір қарағанда қарапайым көрінетін технология Instagram-да бетті әрлеуге арналып жасалған еді. Бірақ қызық болғанымен, одан келетін қауіп те көп. Алдымен, қытайлық технологияға қарай ойыссақ. Deepfakes-as-a-Service (DFaaS) платформасын қолдану үшін 145 доллар төлеу керек. Одан кейін үш минуттық тірілей видео түсіресіз де, 100 шақты сөз айтасыз. Киноөндірісі мен жарнамада қолдануға таптырмас тәсіл дерсіз. Бірақ құқық бұзылса, біршама мәселе туындатуы мүмкін. Технология қарыштап дамыған сайын адамға тигізетін пайдасымен қатар, зияны да болатынын көріп отырмыз. Адамның дижитал көшірмесі бар болса, оның бет-әлпетін, мимикасын, дене бітімін, киімін, даусын — бәрін қойып қоюға болады. Қазіргі уақытта жалған ақпаратқа сенетіндер көп. Сол тұрғыдан алып қарағанда, бұл өте қауіпті. Бір жалған видео желіде тарап кетсе, оны басқара алмай қаласыз. Барлығы демде бөлісіп, шынға ұласып кете салады.

Даму кезеңдері

Кейінгі 20 жылда кинематографта толыққанды дижитал клон жасау үшін CGI (Computer Generated Imagery) технологиясы қолданылып келеді. Көбіне кейіпкерлердің реал анимацияланған 3D-моделін жасауға пайдаланады. Оны күнделікті өмірде фильмдерден көріп жүрміз. Сол арқылы шынайы актердің қимыл-әрекеттерін қайталайды. Сондай кейіпкерлердің бірі — «Сақиналар әміршісі» трилогиясындағы Голлум. Кинематограф тарихындағы тұңғыш компьютерлік кейіпкер сол болған еді. Голлум барынша шынайы актерге ұқсауы үшін фильм жасағандар қимыл-әрекеттер қайталайтын технологияны қолданды. Ал алғашқы «Аватар» шыққан кезде facial motion retargeting технологиясы пайдаланылды. Ол арқылы адамның мимикасы үш өлшемді кейіпкерлерге салынды. Ал оған дейін ондай фильмдерді түсірген кезде қимылды ұстап тұру жүйесі барлығына ортақ еді. Бүгінгі таңда фентези жанрындағы фильмдердің барлығында дерлік осы технологиялар қолданылады. Олар шамамен мың кадрге не кинотаспаның 90 пайызында пайдаланылады. Айтпақшы, осы технология арқылы Cyberpunk 2077 видеоойынының фанаттары Киану Ривзді кейіпкерлердің бірі ретінде көре алды.

Нейрон желілерінің арқасында дижитал аватар жасауға кететін шығын әжептәуір азайды. Кәдімгі цифрлық камераға түсірілген видеоқатарды қолданып, үйретілген машина модельдері бірқатар шаруаны тындыруға қауқарлы. Түрлі текстура қоюға, дауысты көшіруге, қимыл-әрекеттер жасауға, әнге сай қимылдауды үйренді. Толыққанды дипфейк жасап шығару үшін біршама технология қажет. Компаниялар бүгінде аватар жасау сервистерін белсенді қолданып жүр.

Қандай жобалар бар?

2022 жылы NVIDIA компаниясы nstant NeRF моделін жарыққа шығарды. Оның ішінде үйретілген аса жылдам нейрон желісі мен жедел рендериң бар. Оған бар болғаны қозғалыссыз ондаған сурет болса жеткілікті. Сосын сол суреттер түсірілген камераның ракурстары туралы деректер қажет. Осыларды қолданып, 3D-нұсқасы визуалданады. Көз алдыңызға елестету үшін бір адамды барлық қырынан түсіруге тырысып жатқан фотографты ойлап көріңіз. NeRF-ке қажет деректер де осылай жиналады. NVIDIA-дың дауысына қарай анимациялайтын Audio2Face деген технологиясы бар. Бұл қолданбаға кейіпкердің 3D-моделі жүктеледі. Сосын оны аудио арқылы анимациялауға болады. Сол жүктелген аудио терең үйретілген нейрон желісіне жолданып, жасанды интеллект жұмысқа кіріседі.

Келесі технология — VALL-E. Мұны жыл басында Microsoft компаниясы таныстырды. Ол егізіңізді сөйлестуге мүмкіндік береді. Яғни адамның бар болғаны үш секундтық дауысын алып, клондай алады. Әрине, синтез барынша сапалы болуы үшін кемінде 10 сағаттық дауыс жазбасы керек деседі. Тіпті одан да көбірек болса жақсы. VALL-E адамның сөзі мен эмоциясын ғана емес, ол сөйлеп жатқан жердің де дыбысын шығара алады. Айталық, телефон арқылы сөйлескен кезде де клондайды.

Қай кезде қауіпті болуы мүмкін?

Бұған дейін айтқанымыздай, бұл технологияларды қолданатын сала көп. Білім беру саласынан бастап, маркетиңде де кеңінен пайдалануға болады. 2019 жылы Флоридада Dali Lives көрмесі кезінде қонақтарды Сальвадор Далидің өзі қарсы алғандай әсер сыйлаған еді. Яғни нейрон желісі арқылы дижитал көшірме суретшінің өмірбаянын айтып, жетістіктерін тізіп шықты. Мұның бәрі керемет. Дегенмен қауіп те жоқ емес. Ендеше, кемшіліктеріне де тоқталайық. Аватарлар технологиясы дамыған сайын алдағы уақытта қоғам алдында пайда болуы мүмкін қауіптердің де қарасы көріне бастады. Мысалы, осы технологияларды алақтар сәтті пайдалануы мүмкін. Яғни адамдардың даусын ғана емес, толыққанды дижитал көшірмесін қолданып, қитұрқы әрекеттерге баруы ғажап емес. Шын адамнан еш айырмасы жоқ дипфейтерді анықтау қиынға соғатындықтан, бұл ретте этикалық мәселелер де пайда болады. Жасанды интеллект жасаған репликаны пайдалану құқығы қалай іске асады? Мұның барлығы әзірге шегеленбеген. Әйтсе де, дипфейк жасаушылардың алдында осындай күрделі мәселелер тұр. Қауіпсіздік шараларын қамтамасыз етуге көңіл бөлмесе болмайды.

Өзге елдерде қандай шаралар қолданылады?

Twitter, Facebook, TikTok, Reddit секілді әлеуметтік желілер қазіргі таңда қолданушылардың фейктерден қорғауға қатысты саясат әзірлеп, енгізуге тырысып жатыр. Кей елдерде жасанды жолмен жасалғанды белгілеулі міндеттеген. Мысалы, Американың кей штаттарында көрсету керек. Мысалы, Калифорнияда сайлау алдында саясаткерлердің бейнесін қолданып дипфейк жасауға тыйым салынған. Қытайда да арнайы белгімен көрсетіледі. Францияда болса, адамның келісімінсіз дауысы мен суретін монтаждауға қарсы санкция бар.