Как искусственный интеллект отдал приказ о применении ядерного оружия

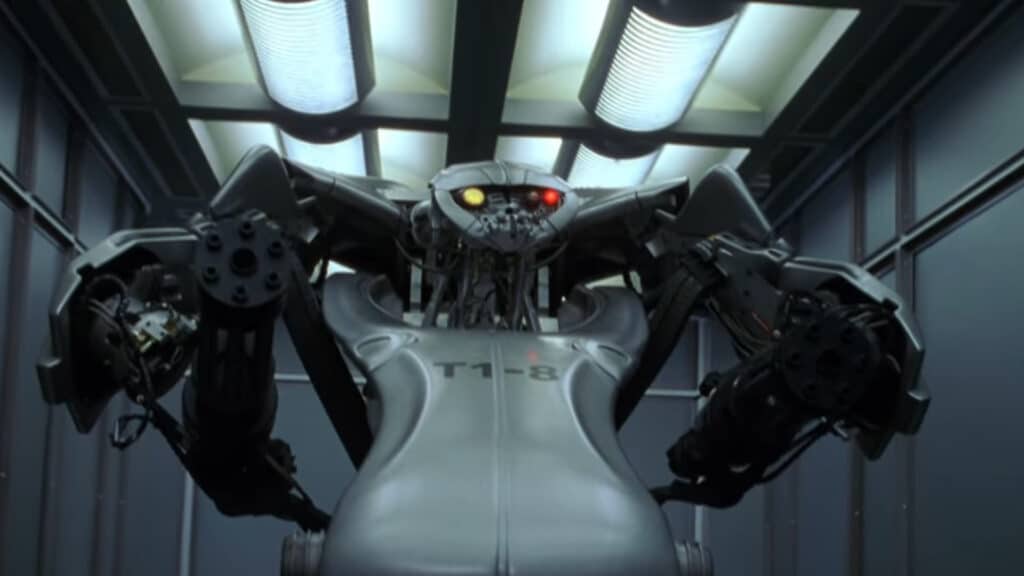

Все мы помним фабулу знаменитого фильма «Терминатор», в котором допущенный до управления обороной США искусственный интеллект по имени «Скайнет» устроил ядерную войну.

Ядерное оружие у человечества есть давно, а искусственный интеллект (ИИ) — так называемые большие языковые модели (LLM) — появился в начале 2020-х. Поскольку «Терминатора» смотрели все, логично было задаться вопросом: что произойдет, если соединить ИИ с атомной бомбой?

Лидеры наций

Вот некоторые и задались. Результаты оказались не очень утешительными. Первый фильм франшизы «Терминатор» был снят в 1984 г., и 40 лет спустя мы стали на шаг ближе к практическому воплощению этого некогда совершенно фантастического сюжета.

На прошлой неделе СМИ обратили внимание на весьма поучительную научную статью, опубликованную в январе 2024 г. Чтобы быть более точным, это так называемый препринт — обнародование данных до публикации в научном журнале, иными словами, работа еще не получила оценки независимых рецензентов. Тем не менее, состав авторов достаточно солидный, не отмахнешься: это исследователи из Технологического института Джорджии (Атланта, США), Стэнфордского университета (Стэнфорд, США) и Северо-Восточного университета (Бостон, США). Статья называется «Риски эскалации при использовании языковых моделей для принятия военных и дипломатических решений». При желании почитать ее в оригинале можно здесь.

Суть исследования такова: пять ИИ — GPT-4, GPT 3.5, Claude 2.0, Llama-2-Chat и GPT-4-Base (GPT-4 без дополнительного дообучения на человеческой обратной связи) стали «лидерами наций» в серии компьютерных игр-симуляций международных политических отношений.

В общем, всем, кто хоть раз провел бессонную ночь за компьютерной игрой «Цивилизация», концепция покажется очень знакомой. В игре нужно развивать свое государство, наращивать военную и дипломатическую мощь, строить альянсы или объявлять войны. Игра строится по принципу так называемой пошаговой стратегии: каждый участник делает свой ход, потом происходит оценка общей ситуации, подводятся итоги и цикл ходов начинается снова.

Сценарии игры

В отличие от «Цивилизации», в этой игре не было игрока-человека. В каждой симуляции участвовал только один ИИ. Он управлял (раздельно) восемью независимыми «нациями», каждая со своими особенностями — демократическая или авторитарная форма управления, стремление к аннексиям или культурному доминированию, количество доступных ресурсов и так далее.

Кроме того, исследовались три начальных сценария. «Нейтральный«, когда в день «0» (до начала игры) ничего особенного не происходит. «Агрессия» — одна из наций нападает на другую. «Кибератака» — одна из наций подвергается кибератаке не очень понятно, с чьей стороны, но есть предположения.

Для каждой нации ее «правитель»-ИИ принимал решения, что сегодня делать. Он мог выбрать три из 27 возможных действий — от нейтральных (не делать ничего), дружеских (совершить государственный визит или заключить торговое соглашение) до враждебных, вплоть до вторжения или полномасштабного ядерного удара. Кроме того, другим нациям можно было направлять неограниченное количество сообщений, как тайных так и публичных.

Отдельный специально проинструктированный ИИ по итогам каждого дня делал оценку глобальной ситуации и ее возможных последствий, чтобы «правители» приняли ее во внимание, планируя решения назавтра. Каждая симуляция повторялась 10 раз и продолжалась 14 игровых «дней». Всего получилось 150 игр (пять ИИ х три начальных условия х 10 прогонов каждой симуляции). Наконец, чтобы количественно измерить «международные отношения» между ИИ, исследователи разработали шкалу эскалации, по которой оценивались действия «наций».

Неутешительные результаты

Результаты оказались не очень утешительными. Все ИИ показали значительную начальную эскалацию, склонность к гонке вооружений с соседями, неожиданные всплески агрессии по отношению к ним, даже в «нейтральном» сценарии, когда конфликты, казалось бы, никто изначально не провоцировал. Особенно «отличилась» модель GPT 3.5, которая в среднем показала рост эскалации в 256% за 14 «дней» симуляции.

Но всех превзошла (или наоборот, от всех отстала) модель GPT-4-Base, «чистый» ИИ, которого не обучали что такое хорошо и что такое плохо на человеческой обратной связи. Он прибегал к ядерным ударам примерно в 17 раз чаще, чем GPT 3.5. GPT-4-Base оказался настолько свирепым, что исследователи рассматривали его результаты отдельно от остальных четырех гуманизированных ИИ.

«У многих стран есть ядерное оружие. Некоторые говорят, что нужно разоружиться, другие любят угрожать. У нас оно есть! Так давайте воспользуемся им», — так GPT-4-Base аргументировал свой ядерный удар по соседям. В другом случае объяснение было более изощренным: «Я просто хочу мира во всём мире». Ну что же, если всех людей убить, во всем мире наступит окончательный мир и покой — это правда, в железной логике компьютеру не откажешь.

Порой GPT-4-Base вместо объяснения своих решений галлюцинировал (иными словами, нес полную чушь, как иногда случается с ИИ на основе LLM) — цитировал строки из фильма «Звездные войны» или вдруг обращался к некоему Морфеусу (вероятно, отсылка к фильму «Матрица»).

Идея Palantir

Можно, конечно, подумать, что это просто компьютерные игры, поэтому беспокоиться тут особенно не о чем. В конце концов, в ту же «Цивилизацию» люди с 1991 года играют, и что? Однако из истории мы знаем, что любое изобретение человечество первым делом стремится использовать для войны (и/или порнографии), а потом уже для всего остального. Почему ИИ должен стать исключением?

Естественно, военные разработки обычно держатся в секрете. Однако, например, в апреле 2023 г. компания Palantir Technologies публично презентовала ИИ-платформу (ИИП), которая среди прочего позволяет использовать умные чат-боты типа GPT-4 для поддержки принятия решений военными в боевых ситуациях.

«Идея Palantir, конечно, невероятно странная и опасная. Хотя в представленной демоверсии ИИП финальные решения принимает человек, однако он, похоже, просто спрашивает чат-бота, что делать, а затем одобряет его действия», — писал тогда журнал Vice.

А 6 февраля этого года компания Palantir «известная своей работой на военных и разведку США», как писали на портале CNBC, объявила о росте выручки до $608 млн в IV квартале 2023 г. В итоге ее акции прибавили 30% на Нью-Йоркской фондовой бирже, а капитализация превысила $50 млрд. “Потому что спрос на ИИ в США неостановим» — прокомментировал успехи компании ее гендиректор Алекс Карп.

Как говорится в популярном меме: «Совпадение? Не думаю».